市场上最先进的旋转代理

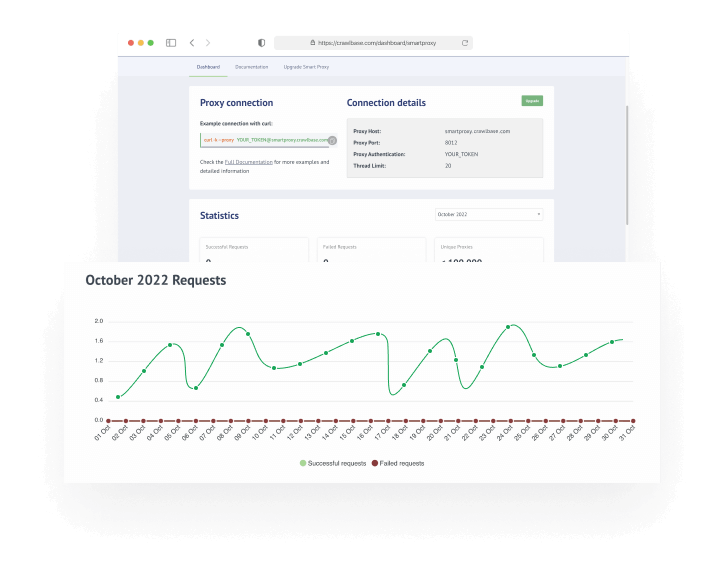

如果您的项目需要带端口的代理主机,那么这就是您的完美产品。

我们的网络工程师团队不断增加可用的代理池,同时删除失败的代理,以确保只有优质代理在网络中处于活动状态。

99%

成功率

100%

网络正常运行时间

24/7

专家团队的支持

通过避免块和验证码实现真正的互联网自由

在 Crawlbase,我们关心数据。 这就是为什么我们创建了智能代理来为每个人打开数据之门。

我们的高级代理池将允许您匿名访问和抓取在线数据,即使在发送数百万个请求时也是如此。 这些质量代理也会定期轮换,以确保您的每个连接请求都不会受到限制、阻止或拒绝。

住宅代理

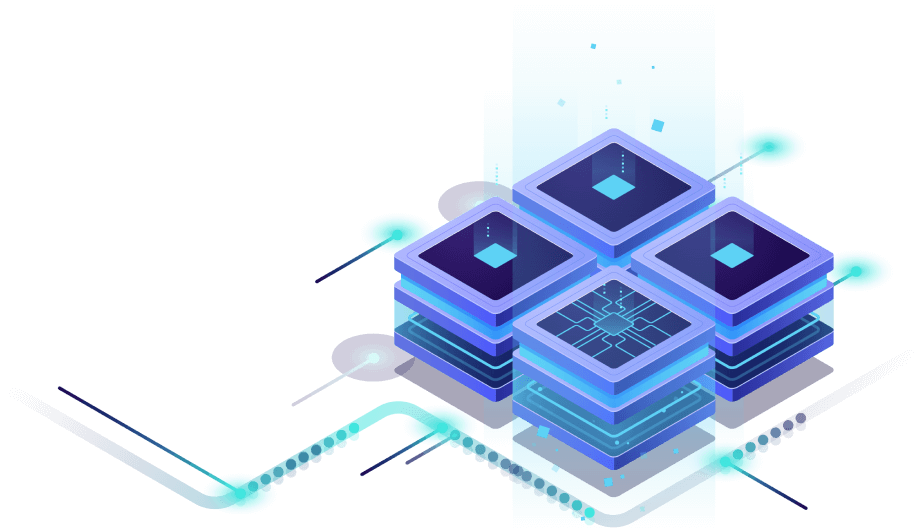

这些是具有 IP 地址的真实设备,由世界各地的 Internet 服务提供商 (ISP) 提供。 如果您希望网络爬虫在抓取数百万个网站时保持匿名,这种私有代理类型是完美的。

阅读更多关于住宅代理的信息建立免费账户!

匿名抓取和抓取网站

在每天处理数百万个请求的同时,保持领先地位并保护您的安全和匿名性。

使用我们的智能代理管理器简化代理管理

我们的智能代理管理器通过代理服务器为您自动进行流量路由。 它避免了服务器过载并有效地处理并发请求。

我们的智能代理管理器速度很快,可确保请求没有延迟。 借助其自动 IP 轮换,您可以轻松绕过限制、避免 IP 禁令并提高网络抓取速度和准确性。 我们的智能代理管理器将平衡负载,以便您可以轻松执行广告验证、市场调查和竞争对手分析,同时为您的网络抓取活动保持最高级别的隐私和安全。

为什么智能代理比反向连接代理更好?

在过去十年中,反向连接代理没有太大变化,这就是为什么在 Crawlbase 中,我们决定进行创新并做出我们认为是代理反向连接的未来的原因。 这就是我们所说的“智能代理”。

我们的智能代理将代理反向连接提升到一个新的水平。 我们在各个方面都显着增强了我们的 Proxy Backconnect 产品,使其比以往任何时候都更智能。

Crawlbase 训练的 AI 避免 CAPTCHA 和块的好处

失败请求的自动重试

在我们的全球基础设施中请求使用无头浏览器的选项

智能池化

提高安全性

增加 IP 轮换

为大客户提供更轻松的访问和可扩展性功能

爬行和刮擦。

为什么选择 Crawlbase 的智能代理?

Crawlbase 受到全球成千上万的个人和公司的喜爱。 我们的产品已经过多次测试,多年来不断产生满意的客户。

在 Crawlbase,我们照顾我们的客户。 我们的工程师团队和支持团队携手合作,提供世界一流的支持,确保每位客户都满意。 我们不会满足于更少,我们一直在努力改进我们的产品和服务。

简单的定价

适用于无隐藏费用的中小型项目。

没有长期合同

免承诺订阅。 随时停止,稍后当您再次需要全球代理时回来。

满意保证

如果您在付款后 24 小时内不满意,要求退款很容易,无需提出任何问题。

常见问题解答

常见问题解答

立即访问有用的功能 报名。

每个包的 IP 轮换量是什么意思?

IP 轮换上指示的数字是您在任何给定时间可以访问的 IP 数量。 让我们以高级套餐为例。 对于此计划,您将可以访问超过 1 万个唯一代理,但并非所有代理都可以同时使用。 您的帐户将在任何给定时间分配 20,000 个 IP,并且当前分配给您的这个 IP 池将随机重置。 每次重置后,您将从超过 20,000 万个 IP 的总池中获得另外 1 个 IP 的访问权限。

您的智能代理计划中指出的这些“线程”是什么?

从技术上讲,智能代理包上指定的线程属于通过程序代码执行的独立路径。 基本上,线程将允许您一次使用多个代理实例。

例如,您可以将线程视为单独的出租车。 因此,在高级套餐的情况下,您最多可以使用 80 辆出租车,每辆出租车一次只能搭载一名乘客。 在一天开始时,他们可以同时接载 80 名乘客并将他们送到他们想要的目的地。 要获得 81 号乘客,您的出租车应先到达目的地并卸下一名乘客。

这些代理可以在我的软件上使用吗?

只要您的软件使用 IPv4 连接并且可以支持 HTTP/HTTPS 代理,我们的智能代理网络将完全兼容。 如果您在集成方面需要进一步帮助,也可以联系我们。

你支持无头浏览器吗?

是的。 可以使用积分来执行普通请求和 JavaScript 请求。 当您需要爬取的内容以 JavaScript(React、Angular 等)呈现或在浏览器上动态生成时,您可以发送 JavaScript 请求。

从快速代理开始

现在开始。 即时设置。