TripAdvisor 是最大的旅游网站之一,拥有大量用户生成的内容,提供了大量对市场研究、竞争分析和其他目的有价值的数据。

TripAdvisor 成立于 2000 年,通过提供旅行者分享体验和见解的平台,彻底改变了人们计划旅行的方式。人们不仅可以阅读评论和评级,还可以查看其他用户上传的照片,以真正了解所期待的内容。最初是一个不起眼的网站,现已发展成为一个拥有数百万用户的全球社区,这些用户为庞大的旅行相关内容数据库做出了贡献。

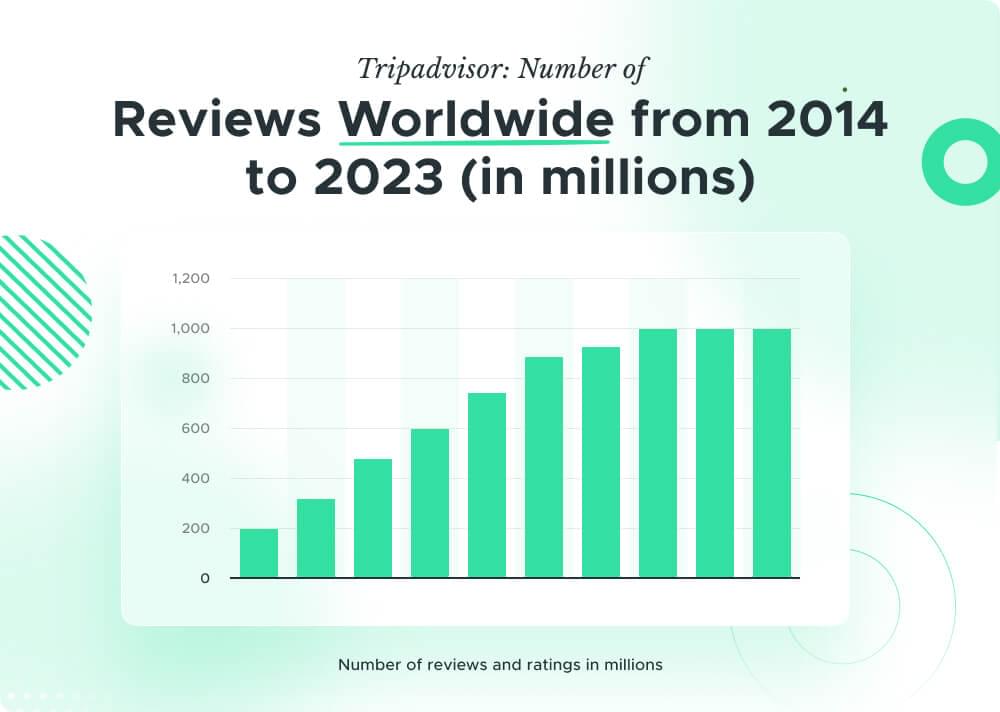

TripAdvisor.com 每月吸引数百万访问者,巩固了其作为全球访问量最大的旅游平台之一的地位。该平台拥有包含近 1000 亿条评论和意见的庞大数据库,为寻求目的地和场所见解的旅行者和食客提供了大量信息。庞大的数据量凸显了 TripAdvisor 作为做出明智决策的首选资源的地位。

在本文中,我们将探讨抓取 TripAdvisor 的好处以及如何使用 Python 编程语言和智能代理来实现它。

目录

- 安装 Python 和库

- 选择 IDE

- 使用 Crawlbase 智能代理发送请求

- 将爬网 API 参数与智能代理结合使用

- 处理 JavaScript 密集型页面

- 抓取名称

- 刮擦评级

- 抓取评论很重要

- 刮痧位置

- 从所有搜索结果中抓取数据

- 处理分页

- 将抓取的数据保存到 Excel 文件中

1. 为什么要抓取 TripAdvisor?

从 TripAdvisor 抓取数据的优势有多种原因。首先,TripAdvisor 提供大量有关酒店、餐厅、景点等的信息。通过抓取这些数据,您可以深入了解客户评论、评级和其他相关详细信息,从而帮助您获得更多收益 满足您的业务或个人需求的明智决策.

抓取 TripAdvisor 也有助于开展 市场调查。通过分析用户评论和评分的趋势,您可以识别热门旅游目的地,了解客户偏好,并相应地定制您的业务策略。此外,抓取 TripAdvisor 可以帮助 竞争分析 通过提供竞争对手绩效和客户反馈的全面概述。

此外,抓取 TripAdvisor 可以成为监控您自己的宝贵工具。 企业的在线声誉。通过跟踪一段时间内的评论和评级,您可以衡量客户满意度,及时解决任何负面反馈,并利用正面评论来提升您的品牌形象。该数据还可用于衡量 您的营销活动和客户服务计划的有效性,让您能够做出数据驱动的决策,以改善客户体验。

此外,抓取 TripAdvisor 还可以发现可能不那么明显的隐藏见解。通过深入研究用户生成内容的细微差别,您可以发现 新兴趋势、客户情绪和需要改进的领域 这可以给您带来市场竞争优势。这种详细的分析可以为组织内的战略规划和决策提供有价值的情报。

2. TripAdvisor 上提供的关键数据

TripAdvisor 提供的信息不仅仅是酒店详细信息。此外 酒店名称、地址、评级、评论、照片、设施和价格,该平台还提供有关旅行世界的宝贵见解。 TripAdvisor 还提供以下数据: 餐厅、景点和航班,让您可以收集有关热门餐饮场所、必游旅游景点和航班选择的见解。来自用户生成的内容,例如 旅游指南、论坛和旅游博客 实时更新 旅行限制和安全措施, TripAdvisor 是所有与旅行相关的事情的一站式中心。

3. 抓取 TripAdvisor 的挑战

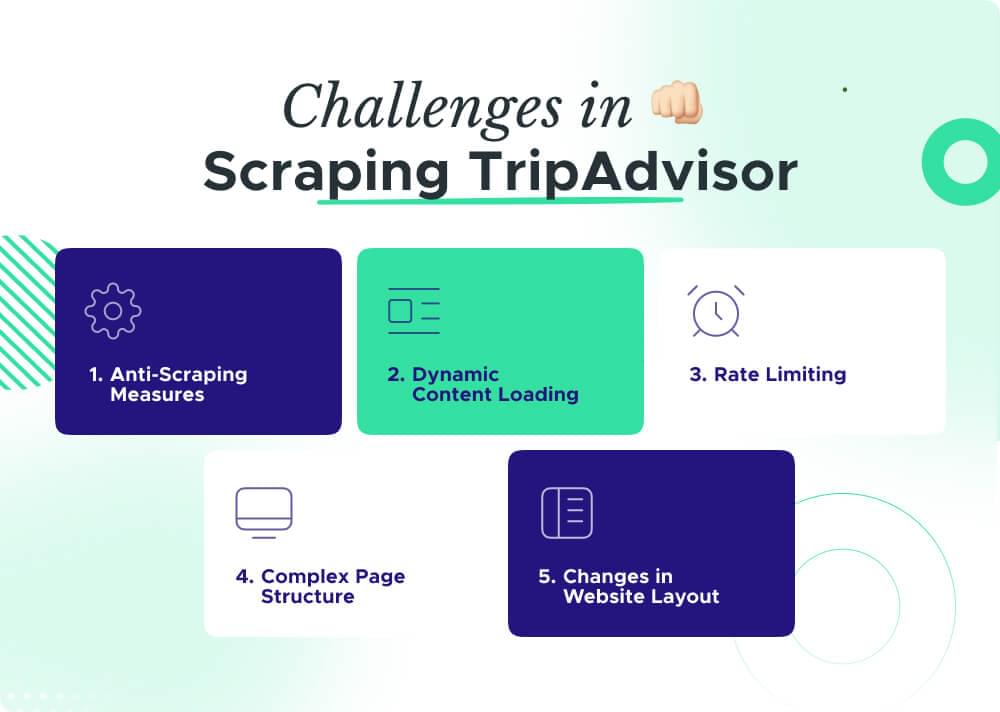

虽然抓取 TripAdvisor 非常有益,但该过程也存在各种挑战。

防刮措施

TripAdvisor 采用保护措施来防止自动抓取,这使得传统方法变得棘手。像 Crawlbase 这样的智能代理有助于绕过这些防御,确保顺利提取数据。

动态内容加载

TripAdvisor 经常使用 JavaScript 动态加载其内容,这使得捕获所有信息变得具有挑战性。使用具有 JavaScript 渲染功能的智能代理对于完整且准确的抓取至关重要。

速率限制

为了避免服务器过载,TripAdvisor 可能会实施速率限制,限制请求数量。智能代理可以通过提供 IP 地址池来帮助管理此问题,防止您的抓取活动被阻止。

复杂的页面结构

TripAdvisor 页面的结构可能很复杂,导致定位和提取特定数据点变得困难。制作精确的抓取脚本并使用智能代理有助于应对这些复杂性。

网站布局的变化

TripAdvisor 会定期更新其网站布局,这可能会破坏现有的抓取脚本。定期监控和调整脚本以及智能代理的敏捷性可确保不间断的数据检索。

为了克服这些挑战,我们可以使用具有 JavaScript 渲染和 IP 轮换等功能的代理。调整抓取策略、采用速率限制策略以及密切关注网站的任何更新将有助于让您在 TripAdvisor 上的抓取工作长期有效。

4. 抓取 TripAdvisor 的代理

成功且高效的抓取的一个关键方面是使用代理,尤其是在处理像 TripAdvisor 这样的大规模抓取项目时。代理充当抓取工具和目标网站之间的中介,掩盖您的 IP 地址,并使您能够在不引起怀疑的情况下发出多个请求。

尤其是智能代理,提供了增强抓取体验的高级功能。这些代理可以 轮换IP地址,跨不同 IP 位置分发请求,并提供更高级别的匿名性。通过轮换 IP 地址,您可以避免 IP 封禁, 访问被阻止的网站,确保刮削作业不间断。

选择用于抓取 TripAdvisor 的代理时,必须考虑速度、位置多样性和正常运行时间等因素。中的一个 最佳代理提供商 目前市场上有售的是 Crawlbase。 Crawlbase 智能代理 由大量的池组成 数据中心 和 住宅代理 worldwide 进行了优化,以通过快速多线程操作实现最高效率。

5. 环境设置

在我们深入抓取 Realtor.com 之前,让我们先设置我们的项目以确保我们拥有所需的一切。我们将通过使用来保持简单 要求, 美丽的汤4 和 大熊猫 用于抓取的库。

安装 Python 和库

Python安装:

- 如果您的系统上尚未安装 Python,请访问 python.org,获取最新版本,然后按照安装步骤进行操作。

- 安装时,不要忘记勾选“将 Python 添加到 PATH”框,以便轻松访问 Python 命令行。

库安装:

- 打开命令提示符或终端。

- 键入以下命令来安装必要的库:

1 | 点安装请求 |

- 这将安装用于处理 Web 请求的 requests,用于解析 HTML 的 beautifulsoup4,用于组织和操作数据的 pandas。

选择 IDE

成功安装 Python 和必要的库后,让我们通过选择集成开发环境 (IDE) 来增强我们的编码之旅。 IDE 是一种软件应用程序,它提供了一整套工具来简化编码过程。

流行的 IDE:

有多种可用的 IDE,一些流行的 Python IDE 包括:

- Visual Studio代码:Visual Studio Code 是轻量级且用户友好的,非常适合初学者。

- PyCharm:PyCharm 功能丰富,广泛应用于专业环境中。

- Jupyter笔记本:Jupyter Notebook 非常适合交互式和探索性编码。

安装方式:

- 从提供的链接下载并安装您选择的 IDE。

- 请按照适用于您的操作系统的安装说明进行操作。

现在我们的项目已经建立,我们准备开始抓取 TripAdvisor。在下一节中,我们将在使用 Crawlbase 智能代理抓取 TripAdvisor 之前了解它。

6. Crawlbase 智能代理

抓取 TripAdvisor 需要采用智能方法,而 Crawlbase Smart Proxy 是您克服障碍和增强抓取能力的关键盟友。让我们探索使其成为网络抓取世界中无价资产的关键功能。

使用 Crawlbase 智能代理发送请求

通过 Crawlbase 智能代理执行请求轻而易举。您需要一个下面是一个简单的 Python 脚本,展示如何使用此智能代理发出 GET 请求。

1 | 进口 要求 |

该脚本配置智能代理 URL,定义目标 URL,并利用请求库来执行 GET 请求。这是利用 Crawlbase 智能代理功能的基本步骤。

将爬网 API 参数与智能代理结合使用

Crawlbase 智能代理允许您使用以下方式微调您的抓取请求 抓取接口参数。这种级别的定制增强了您有效提取特定数据的能力。让我们看看如何整合这些参数:

1 | 进口 要求 |

在上面的例子中,我们使用 国家 值为“US”的参数来定位我们对美国的请求。

处理 JavaScript 密集型页面

TripAdvisor 与许多现代网站一样,严重依赖 JavaScript 来加载内容。 Crawlbase 智能代理为支持 JavaScript 的无头浏览器提供支持,确保您的抓取工具可以访问动态生成的内容。通过使用激活此功能 JavaScript的 参数如下:

1 | 进口 要求 |

通过将 Crawlbase 智能代理与启用 JavaScript 渲染的功能相结合,您的抓取工具能够从 TripAdvisor 捕获有意义的数据,甚至在 JavaScript 密集型页面上也是如此。

在接下来的部分中,我们将深入研究在实际场景中使用这些功能,有效地抓取 TripAdvisor SERP 数据。

7. 抓取 TripAdvisor SERP 数据

从 TripAdvisor 搜索引擎结果页面 (SERP) 中抓取有价值的信息需要精确度。让我们详细介绍一下如何使用启用了 JavaScript 渲染的 Crawlbase 智能代理从所有搜索结果中抓取名称、评级、评论和位置等关键详细信息。

在我们的示例中,让我们重点关注与搜索查询“伦敦”相关的数据。

导入库

为了开始我们的 TripAdvisor 抓取冒险,让我们导入必要的库。我们需要 requests 来发出 HTTP 请求,并需要 BeautifulSoup 来解析 HTML。

1 | 进口 要求 |

这些库将帮助我们轻松发出请求、处理 JSON 响应并解析 HTML 内容。

获取 TripAdvisor 页面 HTML

首先,让我们使用 Crawlbase 智能代理并启用 JavaScript 渲染来检索 TripAdvisor 页面的 HTML 内容。我们还将利用 page_wait 参数值为 5000,以在捕获 HTML 之前引入 5 秒的延迟。这个额外的等待可确保所有 JavaScript 渲染完成。

1 | # 使用您的访问令牌设置智能代理 URL |

抓取 TripAdvisor 搜索列表

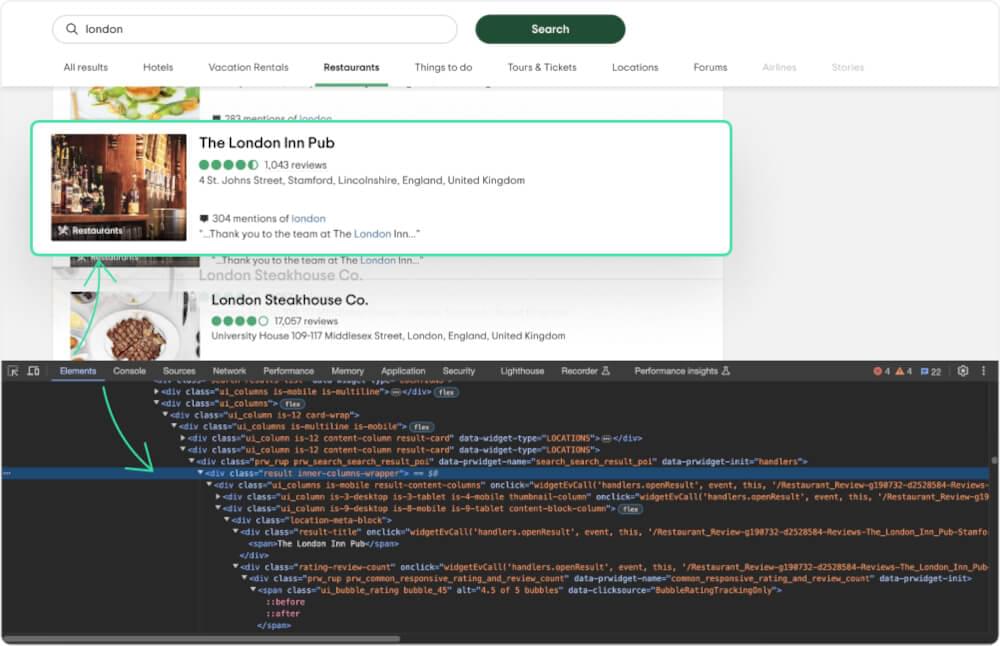

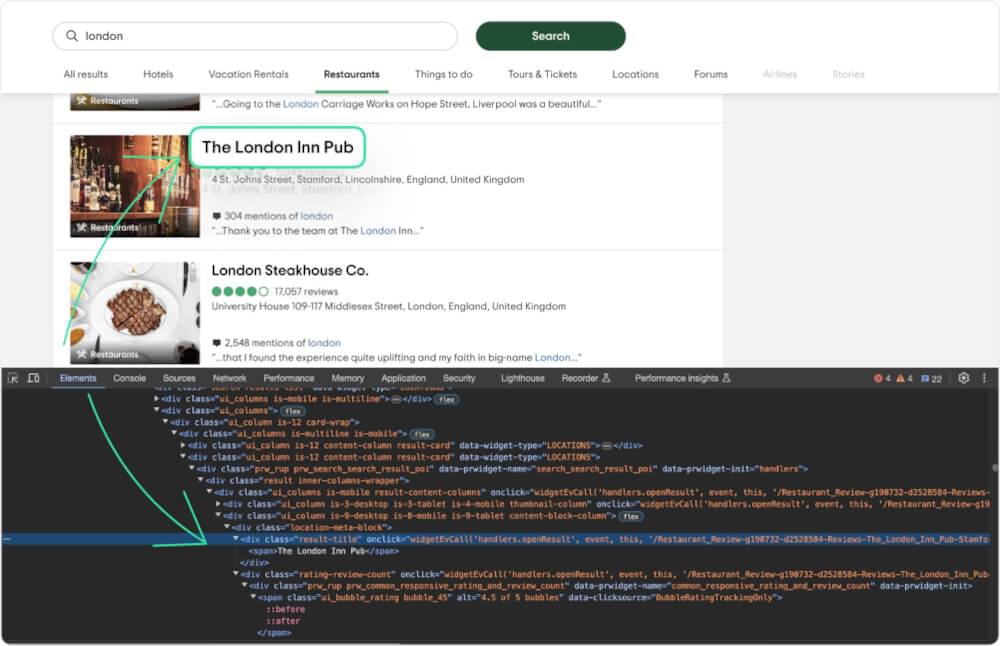

为了获得搜索结果,我们首先需要识别 CSS 选择器,它允许我们定位所有搜索结果。随后,我们可以循环遍历它们以提取各种细节。

只需使用 Web 浏览器的开发人员工具即可探索并找到 CSS 选择器。转到网页,单击鼠标右键,然后选择“检查”选项。

每个结果都在一个 div 与一个班级 result。为了只获取搜索结果列表,我们可以使用 div 有课 search-results-list 和 data-widget-type as LOCATIONS。我们将使用 BeautifulSoup 解析 HTML 并使用找到的选择器定位相关元素。

1 | # 使用 BeautifulSoup 解析 HTML |

抓取 TripAdvisor 名称

让我们重点关注提取搜索结果中列出的地点的名称。

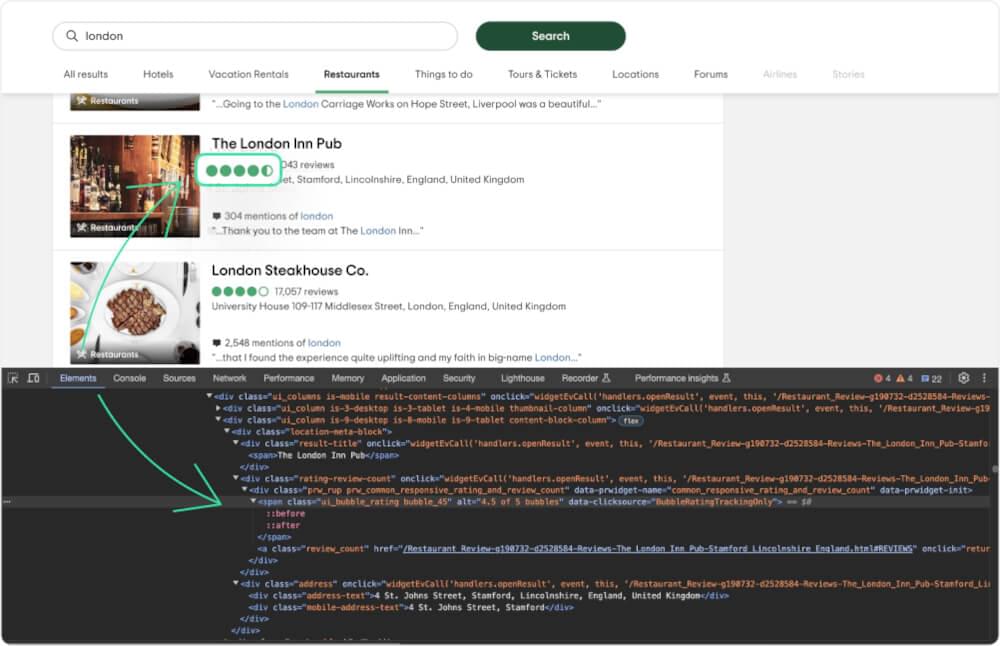

当您检查名称时,您会看到它包含在 <span> 字幕可视电话用于 <div> 上课 result-title.

1 | # 选择名称元素 |

抓取 TripAdvisor 评分

接下来,我们来获取这些地方的评分。

<span> 部分拥有一个名为 ui_bubble_rating,评级可以在 alt 属性。我们可以如下获取评级。

1 | # 选择评级元素 |

抓取 TripAdvisor 评论计数

现在,让我们统计一下每个地方收到的评论数量。

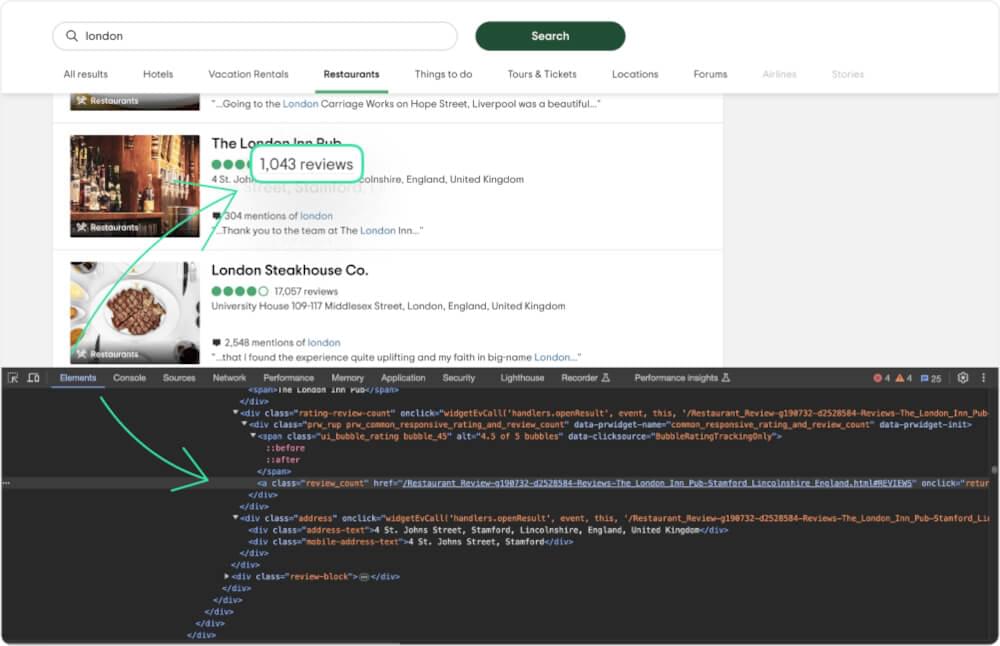

您可以从以下位置获取评论数 <a> 带有类的标签 review_count.

1 | # 选择评论元素 |

抓取 TripAdvisor 位置

最后,让我们获取位置详细信息。

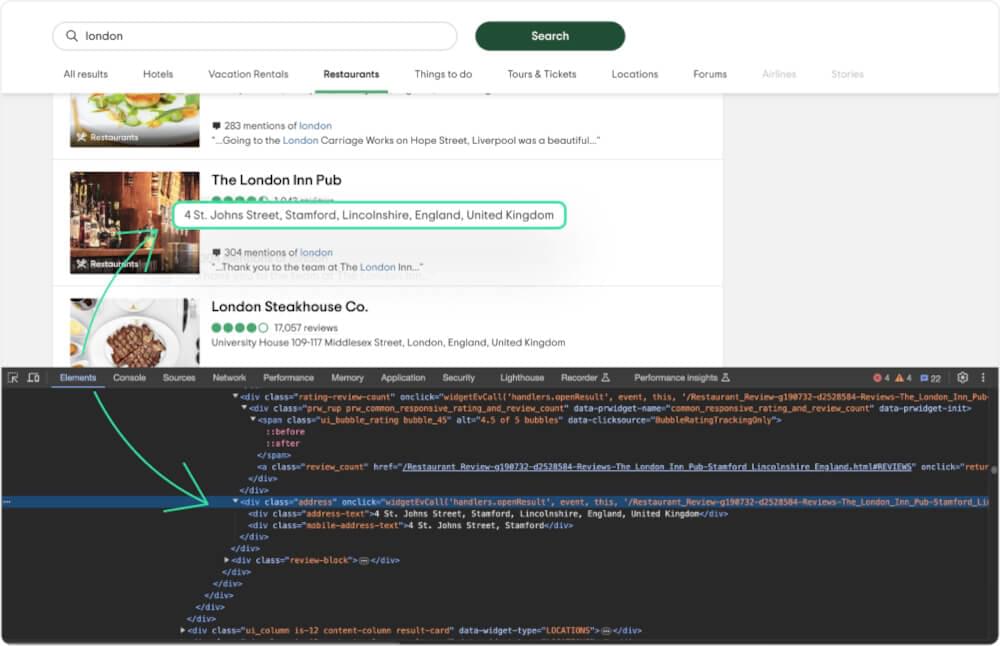

位置可以在 div 有课 address-text.

1 | # 选择位置元素 |

完整的代码

这是集成所有步骤的完整代码。该脚本还会以 json 格式在终端上打印结果:

1 | 进口 要求 |

示例输出:

1 | [ |

8. 处理分页和保存数据

在抓取 TripAdvisor 时,处理分页对于收集全面数据至关重要。此外,还必须 保存抓取到的数据 有效率的。让我们探讨如何处理分页并将结果存储在 Excel 文件中。

处理分页

TripAdvisor 使用“&o”参数来管理分页,确保每个页面显示一组不同的结果。要抓取多个页面,我们可以调整参数值。

1 | 进口 要求 |

将抓取的数据保存到 Excel 文件中

现在,让我们将收集到的数据保存到Excel文件中,以便于分析和共享。

1 | # 扩展之前的脚本 |

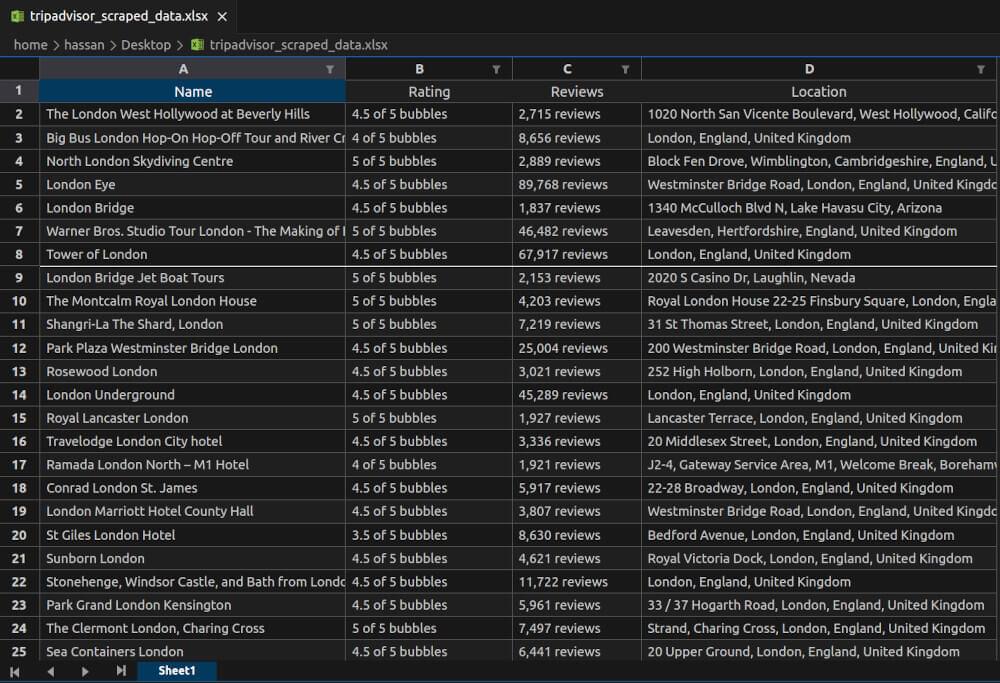

此代码使用 pandas 库将抓取的结果转换为 DataFrame,然后将其保存到名为的 Excel 文件中 tripadvisor_scraped_data.xlsx.

tripadvisor_scraped_data.xlsx 快照:

通过结合这些技术,您可以跨多个页面系统地抓取和存储 TripAdvisor 数据。

9. 最后的想法

在 Crawlbase 的帮助下抓取 TripAdvisor 智能代理 为数据爱好者打开了一个充满可能性的世界。使用正确的工具可以克服反抓取措施和动态内容加载等挑战。 Crawlbase 智能代理使您能够无缝发送 IP 旋转请求并浏览 JavaScript 密集型页面。

如果您想了解有关在抓取网站时使用代理的更多信息,请查看我们的以下指南:

如果您需要帮助或遇到困难,友好的 Crawlbase支持团队 是来帮忙的。快乐刮擦!

10. 常见问题 (FAQ)

问:抓取 TripAdvisor 是否合法?

您可以自由抓取公共数据,包括 TripAdvisor。然而,彻底审查 TripAdvisor 的条款、确保遵守其政策并检查当地法律至关重要。此外,请遵守 TripAdvisor 网站的指南 robots.txt 文件,因为它传达了哪些部分不应被爬网或抓取。谨慎行事并遵守法律准则对于负责任地解决这一问题至关重要。

问:如何在 TripAdvisor 上处理动态内容加载?

处理 TripAdvisor 上的动态内容需要利用诸如 Crawlbase 智能代理。使用此工具启用 JavaScript 渲染对于确保页面上的动态元素完全加载至关重要。此功能至关重要,因为 TripAdvisor 经常使用 JavaScript 来动态加载内容,如果没有它,可能会错过重要信息。通过使用 Crawlbase 智能代理,您可以增强抓取能力,使您的数据提取更加全面和准确。

问:是否可以抓取 TripAdvisor 搜索结果的多个页面?

绝对地!抓取 TripAdvisor 搜索结果的多个页面是完全可行的。这涉及在抓取脚本中实施有效的分页策略。通过不同页面的系统导航,您可以捕获更广泛的数据集,确保您不会错过分散在各个结果页面中的有价值的信息。

问:TripAdvisor 更改网站布局时是否需要更新抓取脚本?

是的,定期更新抓取脚本是必要的。 TripAdvisor 与许多网站一样,其布局可能会随着时间的推移而发生变化。这些修改可能会影响现有抓取脚本的功能。通过使您的脚本保持最新状态并对任何更改保持警惕,您可以确保更可靠且不间断的抓取过程。积极主动地响应变更是维持最佳抓取结果的关键。

问:TripAdvisor 允许网页抓取吗?

不可以,TripAdvisor 不允许网页抓取,但抓取姓名、地址、评论等公开数据是合法的。使用 Crawlbase 智能代理等专用代理来获取位置等信息。