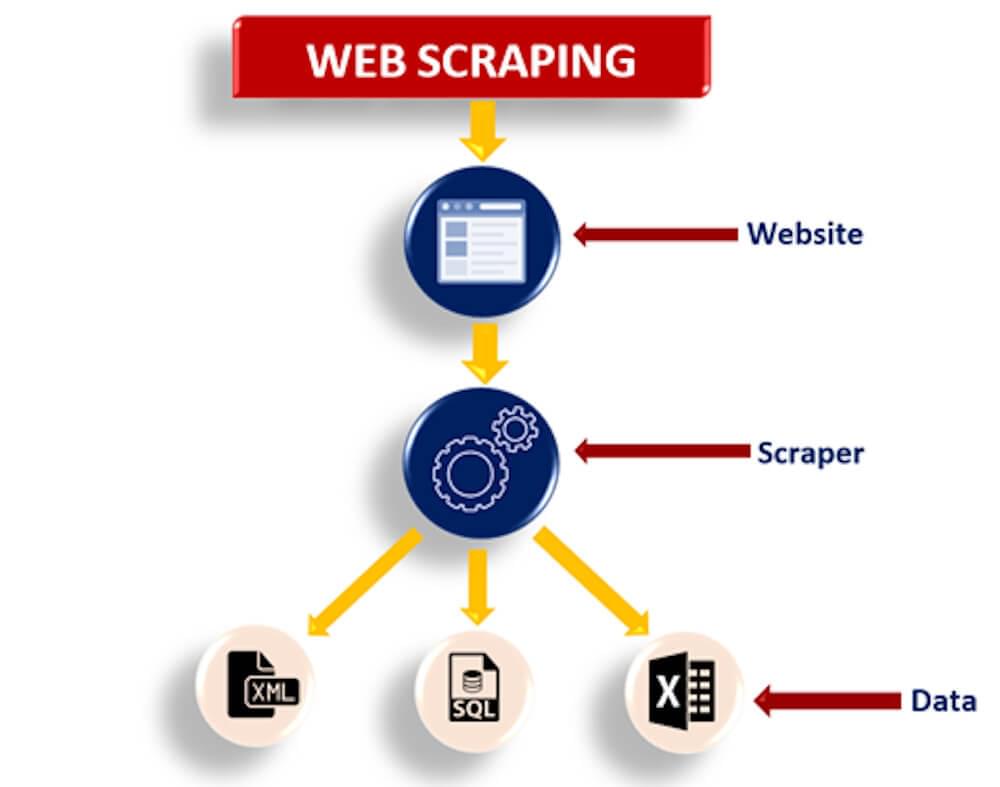

网页抓取 是一种用于从在线页面中提取大量内容的策略,其中信息可以保存到本地存储或表格电子表格中的数据集。 用作网络抓取选项的其他词包括术语屏幕抓取、网络数据提取、网络收集等。 它是自动执行此交互而不是手动从站点复制信息的策略。

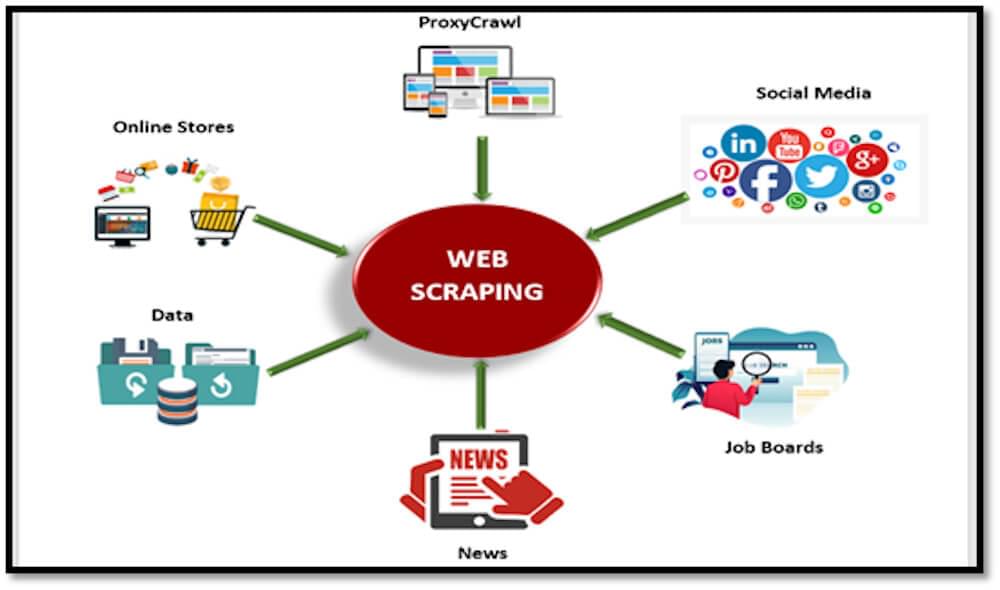

网页抓取主要用于从网站收集大量数据。 无论如何,为什么有人需要从网站中提取如此庞大的信息? 为了考虑这个前提,让我们引用它的一些用途:

- 网络抓取用于从互联网购物网站收集信息,并用它来分析商品的成本。

- 许多组织利用电子邮件作为推广其产品的一种方式。 Web 抓取通常用于收集电子邮件 ID 并随后发送大量消息。

- 用于从 Twitter 等社交媒体网站收集信息,以发现正在发生的事情。

- Web 抓取也是一种从站点收集大量数据(统计数据、一般信息、温度等)的有效方式,这些数据被调查并用于 网站反馈调查 或研发。

用于数据抓取的方法

互联网是世界数据的巨大存储,无论是文本、媒体还是其他配置的信息。 每个页面都以一种或另一种结构显示信息。 接受此信息对于大多数组织在尖端世界中的成就具有重要意义。 可悲的是,这些信息中的大部分都没有公开。 大多数网站都没有提供将显示的信息保存到您附近的库存或您自己的网站的替代方法。 网页抓取可以通过以下两种方法中的任何一种来完成:

- 通过现成的网页抓取工具抓取网页数据

- 通过编程语言进行网页抓取

根据隐含的情况,这两种方法都非常方便。 我们将在本博客中一一介绍这两种方法,以清楚地了解在各自的场景中应该采用哪种方法。

通过网页抓取工具抓取数据

Web Scraping 工具是专门为从站点中提取数据而开发的。 它们也被称为网络收割工具或网络信息提取工具。 这些工具对任何试图从 Internet 收集某种类型的信息的人都有帮助。 Web Scraping 是一种无需枯燥的排版或复制粘贴的新型信息传递方式。

1.八卦

Octoparse 是一种用于网络抓取的工具,对于编码人员和非编码人员来说都很容易使用,并且以电子商务信息抓取而闻名。 它可以在巨大的范围内(高达数百万)抓取网络信息,并将其存储在有组织的文档中,如 Excel、CSV、JSON 以供下载。 它为客户提供免费安排,并为付费订阅提供初步安排。

2. 刮痧机器人

Scraping-Bot.io 是一种从 URL 中抓取信息的熟练工具。 它提供了根据您的抓取需求调整的 API:一个用于恢复页面原始 HTML 的传统 API,一个在零售网站抓取上花费大量时间的 API,以及一个用于从陆地网站抓取房产信息的 API。

3.xtract.io

xtract.io 是一种适应性强的信息提取软件,可以对其进行修改,以抓取和构建 Web 信息、基于 Web 的媒体帖子、PDF、文本档案、真实信息,甚至消息,并将其构建为可消耗的业务准备配置。

4. 代理

Agenty 是用于信息抓取、文本提取和 OCR 的机器人过程自动化编程。 它使您只需单击几下鼠标即可创建代理。 此应用程序可帮助您重复使用所有准备好的信息进行考试。

5. 导入.io

这个网络抓取工具通过从特定页面引入信息并将信息发送到 CSV 来帮助您构建数据集。 与其他允许您使用 API 和 webhook 将信息集成到应用程序中的信息抓取设备相比,它非同寻常。

6.Webhose.io

Webhose.io 允许直接获取有组织和持续的信息以爬取大量站点。 它允许您访问记录的提要,涵盖超过十年的信息。

7.德喜智能

Dexi quiet 是一款网络抓取工具,可让您将无限的网络信息转化为即时的商业价值。 它使您能够减少开支并为您的协会节省宝贵的时间。

8.解析中心

ParseHub 是一个免费的网页抓取工具。 这个高级网页清理器允许提取信息就像点击您需要的信息一样简单。 与其他信息抓取工具相比,它非同寻常,允许您以任何配置下载抓取的信息以供检查。

9. 数据分析器

此工具可帮助您从网络上获取基于网络的媒体内容。 它是其他网络清理器中的佼佼者,它允许您使用自然语言处理删除基本元数据。

10. 矿工

FMiner 是另一个著名的网络抓取工具,信息提取,滑动屏幕抓取,大规模,以及对 Windows 和 Mac OS 的网络支持。

11. 内容抓取器

对于可靠的 Web 信息提取,这是一个令人难以置信的巨大信息答案。 它是其他网络抓取工具中的佼佼者,可让您扩展您的关联。 它提供了简单易用的功能,例如视觉点和快照管理器。

12.莫曾达

Mozenda 允许您从网站页面中提取文本、图片和 PDF 内容。 与其他帮助您整理并准备发布信息记录的网络抓取工具相比,它非同寻常。

通过编程语言抓取 Web 数据

利用自动交互从网站收集信息称为网络抓取。 一些网站明确禁止客户使用机器人工具抓取他们的信息。 但是,有几种方法可以克服这些障碍并从头开始构建您自己的网络爬虫。 以下是技术概要:

1.爬网基地

爬虫库 API 是最著名的网络抓取 API 之一,可帮助开发人员和组织安全地抓取网站。 它提供了抓取 JavaScript 构建的网页所必需的 HTML,管理自动化浏览器,避免手动人工测试,例如验证码,还处理代理管理。

2。 手册

这是大多数普通客户从 Internet 获取信息的方式。 您喜欢一篇文章,因此您在工作区的 Word 文档中对其重新排序。 这是手动的,因此迟缓且效率较低。 此外,它适用于仅包含基本内容的小块信息。 如果您想保存图片和其他各种类型的信息,它可能无法有效地工作。

3. 正则表达式

对于这种情况,您可以描述需要在内容字符串中协调的示例或标准发音,然后在内容字符串中搜索匹配项。 它在网络搜索索引中被大量使用。 在研究弦乐数据时,标准发音成为不可或缺的因素。 标准发音是一种基本工具,可以处理您的基本必需品。

4. DOM解析

在互联网浏览器的帮助下,项目可以访问客户端内容制作的强大脚本。 解析页面的树状结构描述可以是文档对象模型,也称为 DOM,它有助于在抓取数据时获得对部分页面的准入。 为了给您一个模型,将 HTML 或 XML 记录转换为 DOM。 DOM 所做的是用语言描述记录的结构以及如何获取档案。 PHP 提供 DOM 扩展。

有用的编程语言来抓取网站数据

1.使用Python进行网页爬取

设想您需要从站点中提取大量信息,并且必须尽快完成。 在这种情况下,网络抓取是适当的响应。 Web Scraping 使这项工作变得简单快捷。 在 Python 中,beautiful soup 和其他库以及 Scrapy 等框架都可以帮助您实现目标。

2. 使用 JavaScript/NodeJS 进行网页抓取:

JavaScript 很可能已经成为最著名和最常用的方言,因为它已经看到了巨大的增强功能和运行时的表示,称为 NodeJS。 无论是 Web 还是移动应用程序,JavaScript 目前都有正确的工具。 它有多个 API 支持和帮助 Web 数据抓取的抓取库。

这些只是广泛用于网络抓取的编程语言的两个示例。 为了更好地了解如何从头开始构建刮板,我们在下面准备了一份简短指南。

Scrapy Crawlbase 中间件进行网页抓取的先决条件

- 易趣产品页面 URL

- Python 中所需的库和 API 集成

- Crawlbase API 令牌

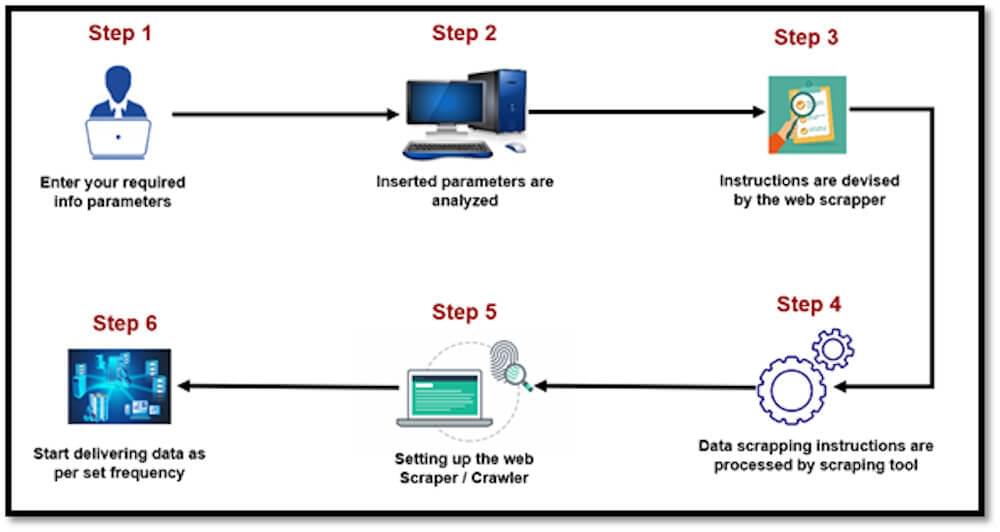

使用 Scrapy 和 Crawlbase 从 eBay 产品页面抓取数据

我们将通过在“/root/spiders”文件夹中创建一个“main.py”文件来导入相关模块,从而获得主蜘蛛的代码。

1 | 止 scrapy_crawlbase 进口 爬取请求 |

然后我们将在 '/root/items.py' 文件夹的 items.py' 文件中有一个可选脚本,在此处定义您抓取的项目的模型。

1 | # 参见文档: |

然后我们要在根文件夹的“middlewares.py”文件中配置 Scrapy 中间件。

1 | # 参见文档: |

然后我们要在根文件夹的“pipelines.py”文件中配置项目管道。

1 | # 在此处定义您的项目管道 |

然后,我们希望通过传递 Crawlbase 令牌并配置 scrapy 蜘蛛,在根文件夹的“settings.py”文件中对抓取器进行设置。

1 | # EbayScraper 项目的 Scrapy 设置 |

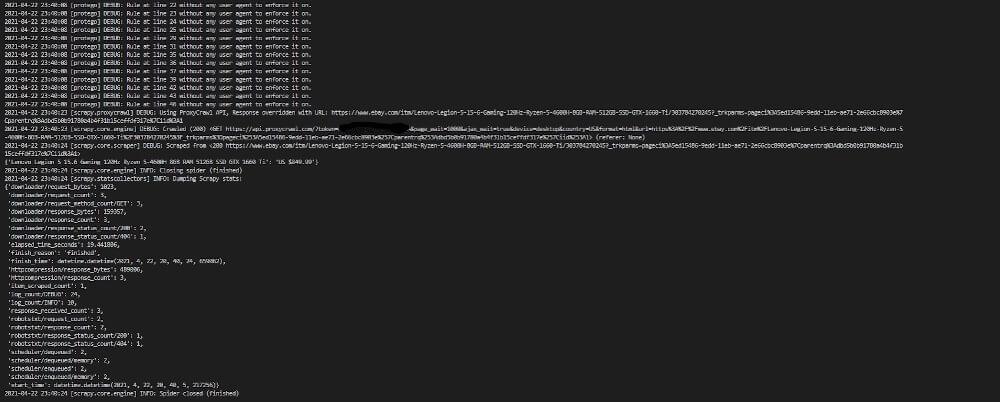

输出

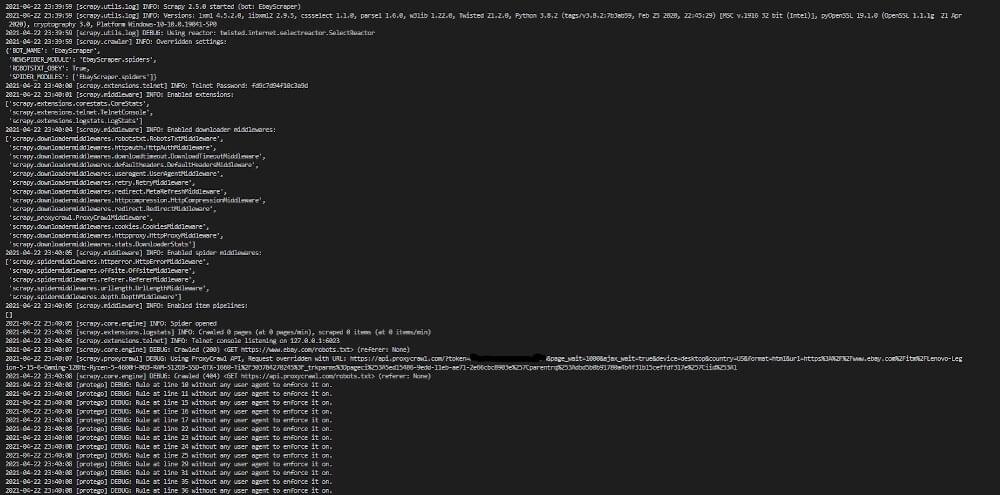

我们现在将在终端中运行“scrapy crawl ebay”命令以获得类似于下图的输出。

这只是一个基本的说明 Crawlbase 的 Scrapy 中间件 API 调用。 您可以从不同的角度进行尝试,看看哪些方法适合您的情况。

结论

网页抓取在生活的各个领域都有很多好处。 它可以提取用于营销目的的数据、联系信息、搜索不同的产品等。实现可以是任何人或组织手动开发的基于代码的解决方案,也可以是可用的网络数据抓取工具利用。 随着新技术的发现,网络抓取的主要影响是永恒的。

爬虫库,您可以抓取和抓取互联网以获取多种类型的数据,从图像、评论、有关产品和服务的详细信息到获取电子邮件、电话号码和潜在开发人员的地址。